“When is AR going to be our default reality?”

During the past decade AR has been going through a transition from niche domain to a mass audience phenomenon. What used to be a lab only experience came into the hand of the public in 2009 with the first AR app on mobile phones. For believers in AR, looking through their screens at a prototype of our future world, it meant that from that moment on anything could be created anywhere by anyone.

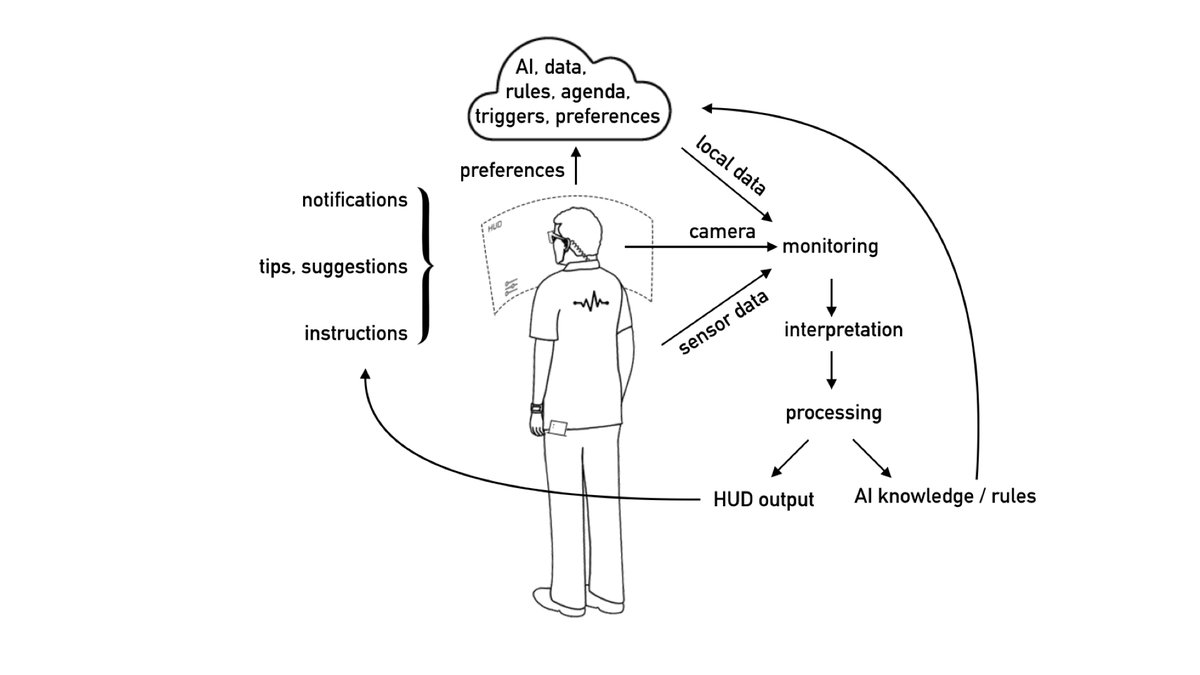

Over the years the quality of the AR experiences has evolved radically. We now have better visuals and the tracking is more stable and reliable. For many domains the technology has finally proven to be truly useful. Still, despite the numerous areas and occasions we find ourselves using AR, it’s not yet playing a major role in our life. But that final step will follow soon. With wearables devices on the horizon, we’re about to enter a new era. The AR enhanced world might become our default reality.

Who will define what’s the default, when we live in a semi-digital world? Will Mark Zuckerberg decide for you what you’ll see, and what not? Or do you prefer to thrust Apple, or even Google? And what will drive the development of our XR life? Will we turn into full time consumers of products, data and services within the ecosystem that captured us? Will there be room for any home-grown content outside the main XR portals? Fortunately, there’s the independent web AR movement. But a technology can only thrive when there are both makers and viewers to use and appreciate about the things being made. The opportunity to life in world that appears as you want it to appear, is amazing. But to enable that, we do need to make sure there is an alternative realm of XR content. That’s not going to happen if we sit still, waiting for our governments to safely guide us into this new world. We need to jump in, try, experiment, understand, try again. Solve problems, at multiple levels. Let’s find ways ways to overcome privacy worries. And there are some practical issues to address too. And on a more fundamental level, we need to answer: what do we want to do in this infinite XR space anyway? What makes us happy, what makes us a human being? Which might become an extra challenge considering that we’re gradually turning into semi-digital beings.

https://www.realities-in-transition.eu/all-news